Generative AI를 위한 최근의 기술 동향

WebAssembly 및 WebGPU 등 트렌디한 기술에 대한 이야기

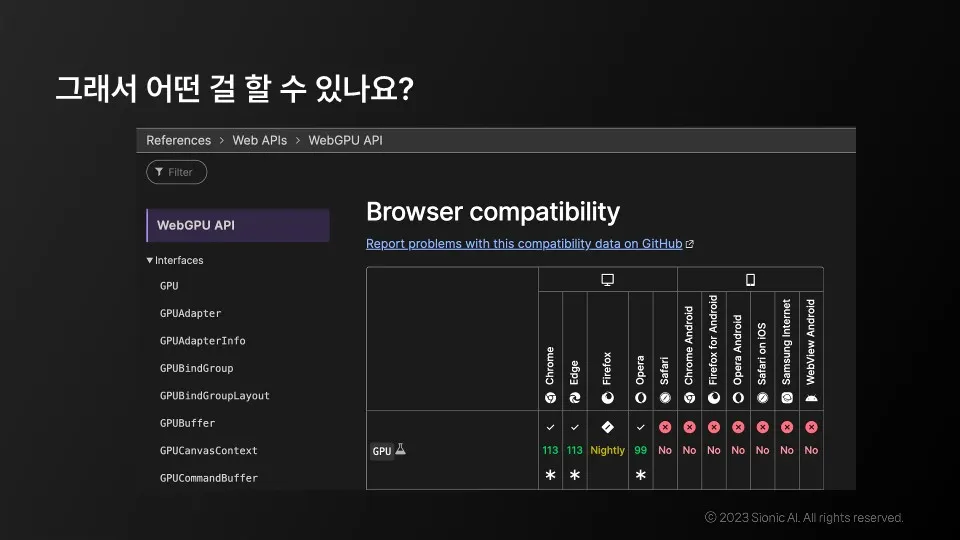

WebGPU

•

WebAssembly 등 비교적 최근에 사용되기 시작하여 자바스크립트 대체재가 아닌 보완재로 기능

•

GPGPU기반 범용 연산 가속이 강점

•

2023년 5월 Chrome113부터 시범적으로 동작

•

Microsoft DirectX, 크로노스 그룹의 벌컨, 애플의 메탈 등

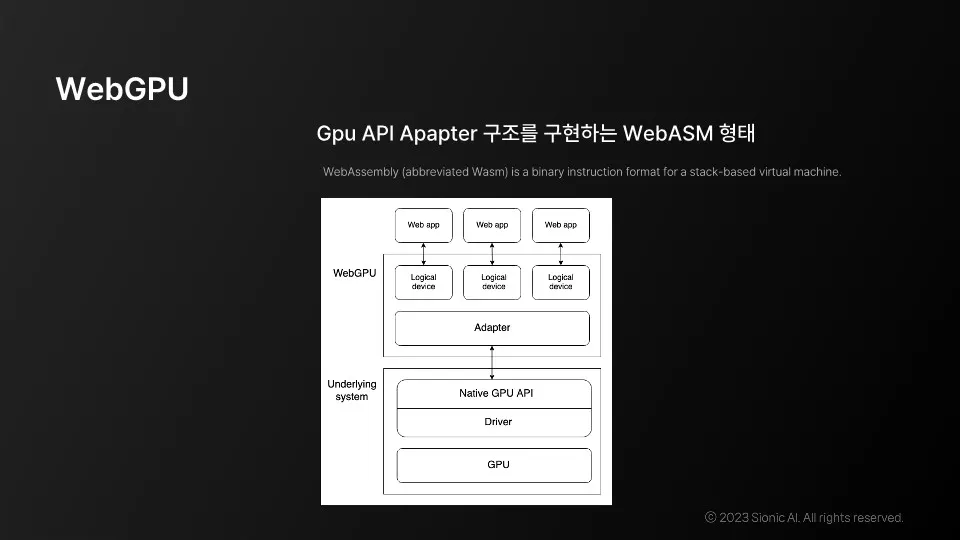

WebGPU 구조

•

웹 기능 확장으로 웹 어셈블리는 네이티브 언어로 구성

•

웹 어셈블리는 컴파일 후 웹을 통해 파일로 전달되어 실행

•

웹 GPU는 웹 어셈블리 기반에서 고성능을 위해 만들어진 (비교적) 고수준 api Apapter 구현

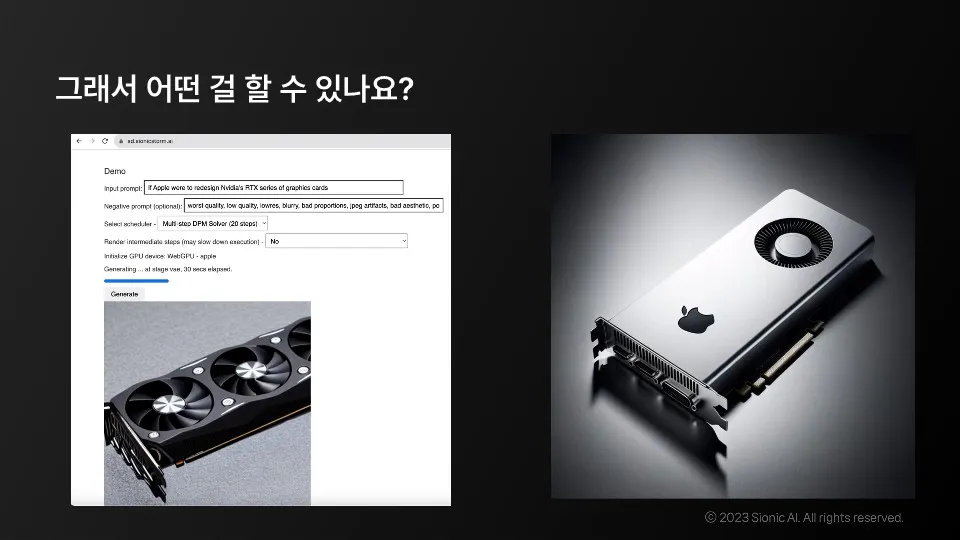

모델 플랫폼의 비용과 기술

•

네이티브 GPU API와 WebGPU API 등 플랫폼 별로 동작

•

Diffusion 모델을 유통하는 플랫폼

•

모델의 비용과 실험 비용 문제 외에도 표준 및 기술적인 문제 등이 존재

현 상황에서 우리가 할 수 있는 것

•

성능과 개인화를 고려한 AI 모델

•

개인화된 LLM은 핸드폰에 탑재되었을 때 AR 기술을 혁신할 가능성이 있음

Web 기반 어플리케이션에서의 Native 지원

•

Chromium 기반 오픈소스의 장점을 취합

•

Electron으로 빌드한 어플리케이션에서 GPU 가속 가능

기술적 선택지를 고민하며 생성형 AR 기술을 활용하는 방법

•

인프라 구축에는 많은 비용이 들지만, 개인화된 LLM과 분리된 GPU 모더를 사용해도 좋은 선택지!!

•

개인화된 LLM은 핸드폰에 탑재하여 AR 기술을 혁신 가능

•

지금은 생성형 AR 기술을 활용하기에 가장 적합한 환경!

•

기존의 네이티브 GPU에 비해서 높은 생산성

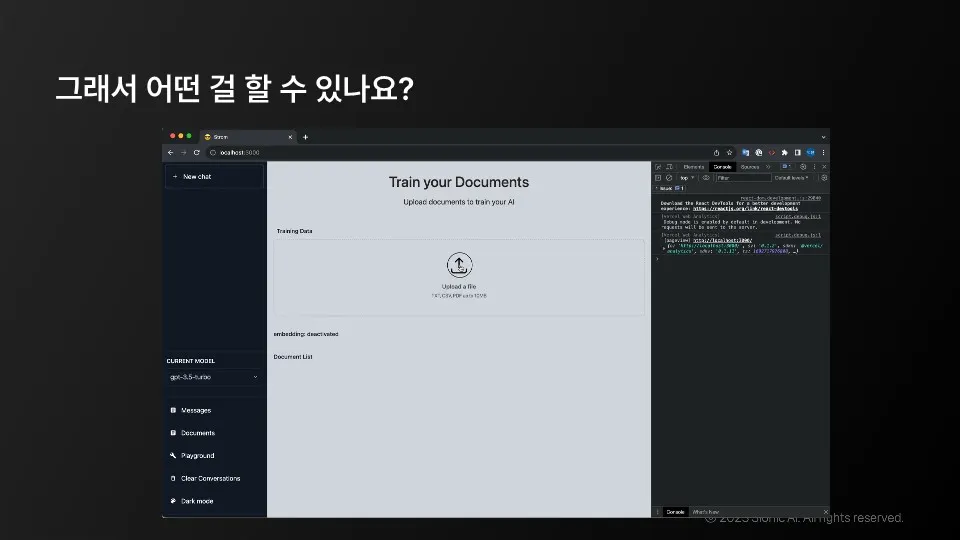

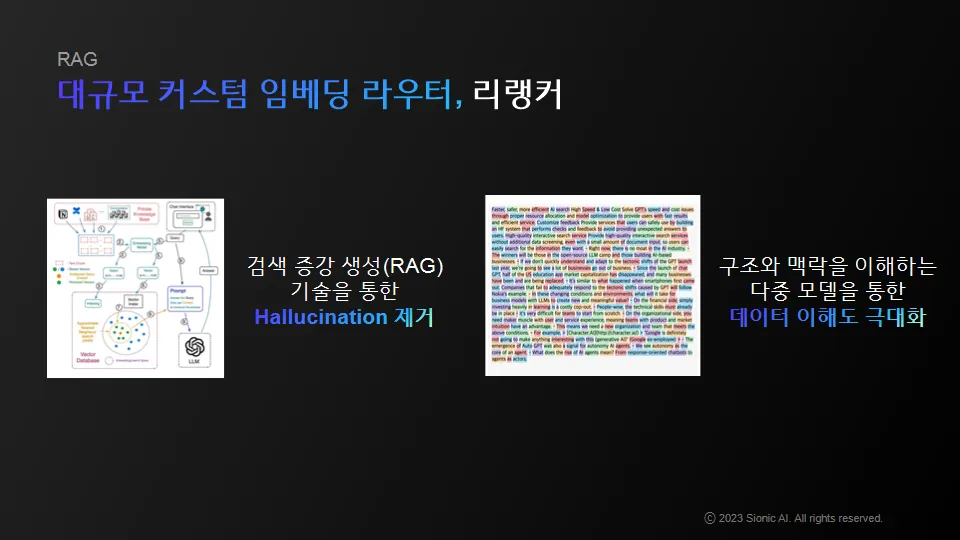

pain point

•

생성형 AI를 완전히 커스텀하기는 어려움

•

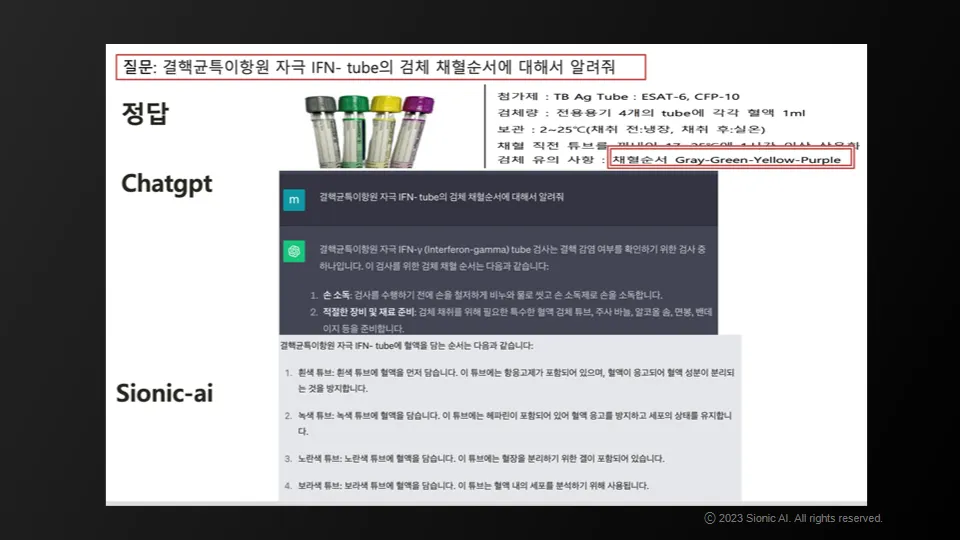

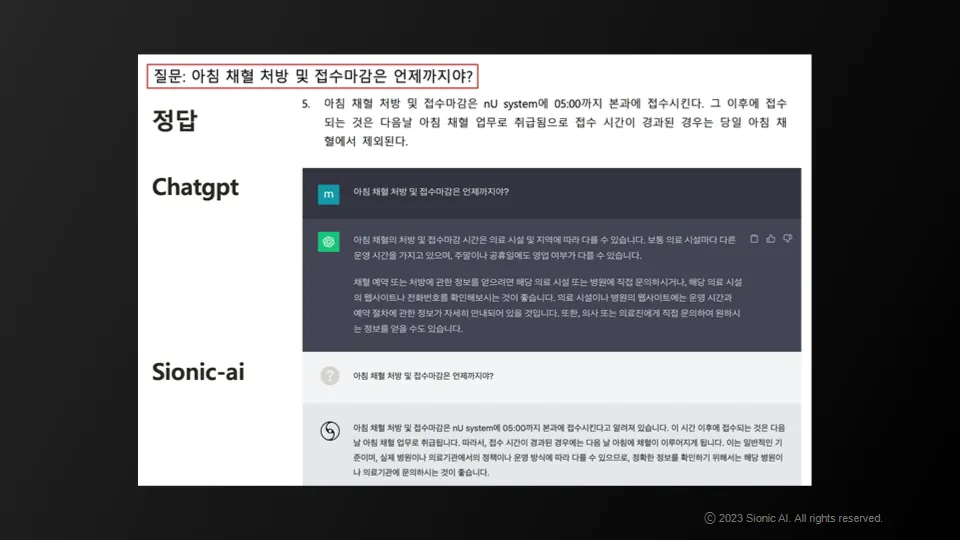

검색 기반 지식을 많이 사용하거나 임베딩 모델 사용

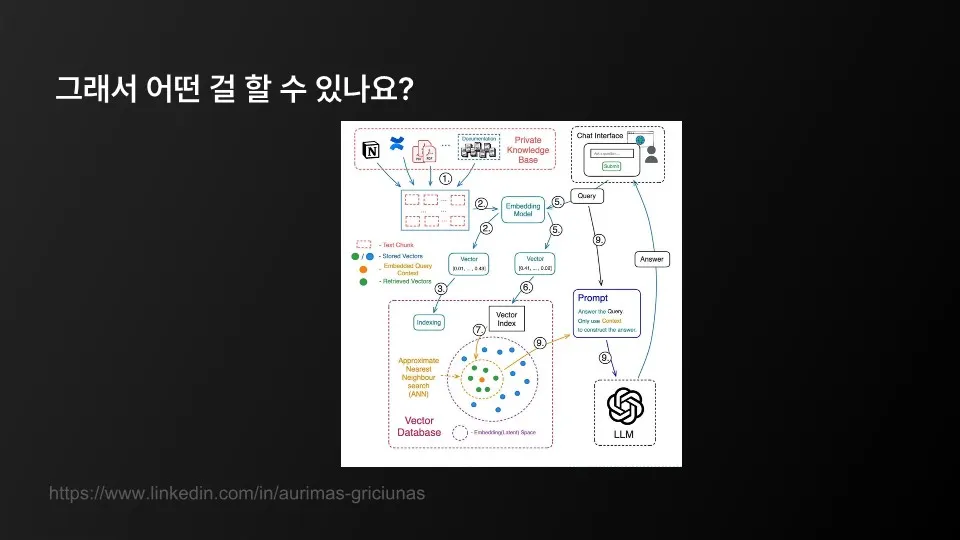

우리가 할 수 있는 전략적 선택

•

튜닝이 틀어지거나 기존의 논리적 지식을 망각하는 문제 해결

•

프라이빗한 지식이 외부로 유출될 가능성을 낮춤

•

벡터 DB를 통해서 프롬프트에 인젝션하는 방식으로 꽤 많은 것들이 해결할 수 있을 것으로 기대

개인화된 LLM을 핸드폰에 넣고 다니면서 이를 통해 세상에 긍정적 영향을 주는 방향성!

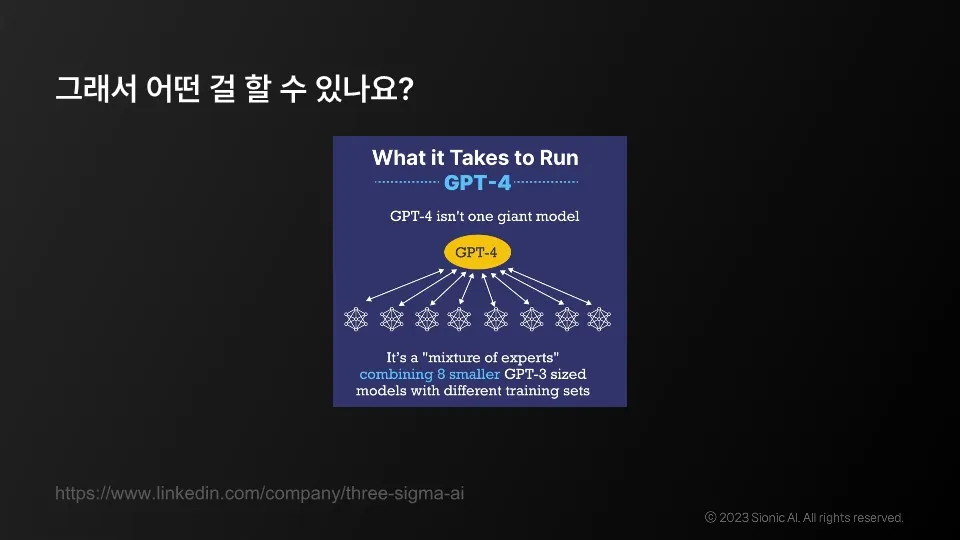

모델 구성

•

인프라 구축에는 많은 비용이 들지만, 개인화된 LLM과 분리된 GPU 모더를 사용하는 것도 좋은 선택지!

•

다만 아직 모바일 지원은 미흡한 초기 단계

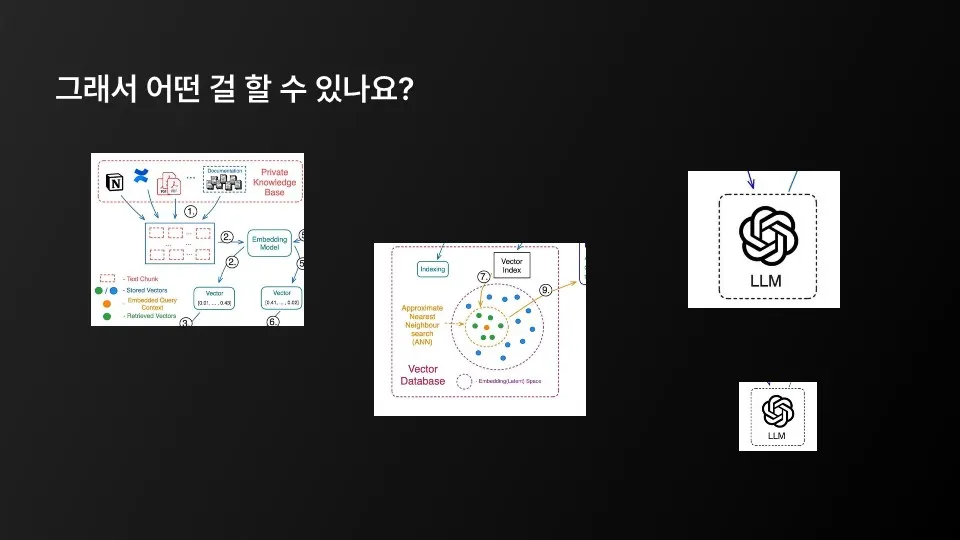

개인화 LLM

•

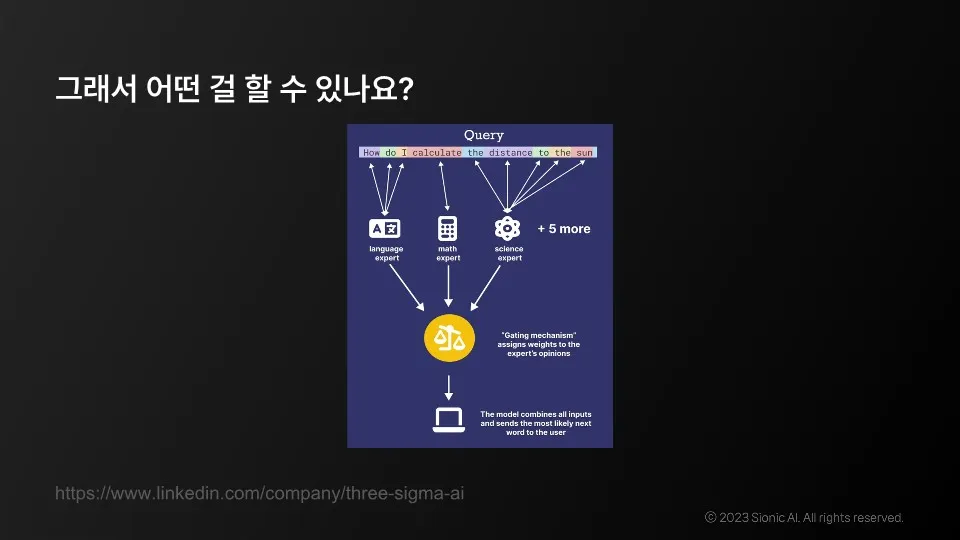

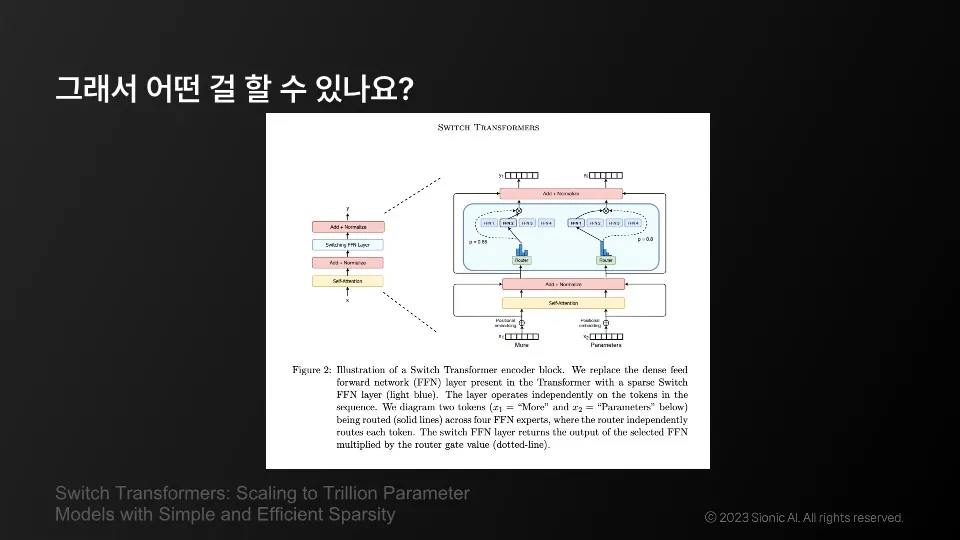

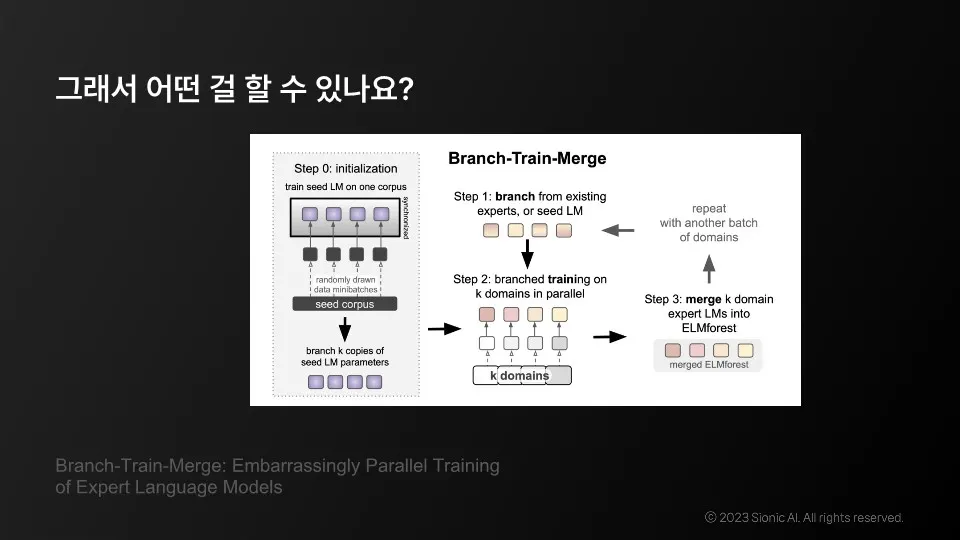

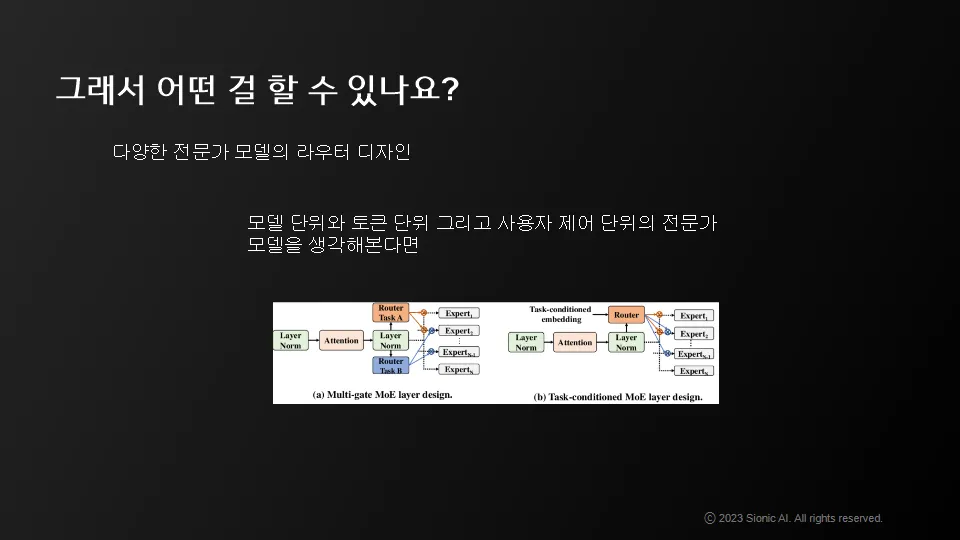

일반적인 언어를 구성하는 모델, 계산력을 담당하는 모델, 과학적 지식과 상식을 담당하는 모델 등 여러 개 전문가 모델을 연합

•

개인화된 LLM을 핸드폰에 탑재하여 AR 기술을 혁신 가능

•

지금은 생성형 AR 기술을 활용하기에 가장 적합한 환경

•

WebGPU를 쓰는 작은 모델이 더 개인적인 LLM을 담당하고 동시에 큰 LLM이 주는 논리적 구조와 답변의 다양성을 사전 지시

•

높은 추론 성능을 가진 LLM 모델을 백본으로 쓰고 우리 회사나 개인에 좀 더 맞춰져 있는 전문가 모델을 개인 디바이스(또는 GPU, 웹사이트)에 휴대

기술적 선택지를 고민하며 생성형 AR 기술을 활용하는 방법

•

인프라 구축에는 많은 비용이 들지만, 개인화된 LMM과 분리된 GPU 모더를 사용해도 좋은 선택지

•

개인화된 LMM은 핸드폰에 탑재하여 AR 기술을 혁신할 수 있음

•

지금은 생성형 AR 기술을 활용하기에 가장 적합한 환경

•

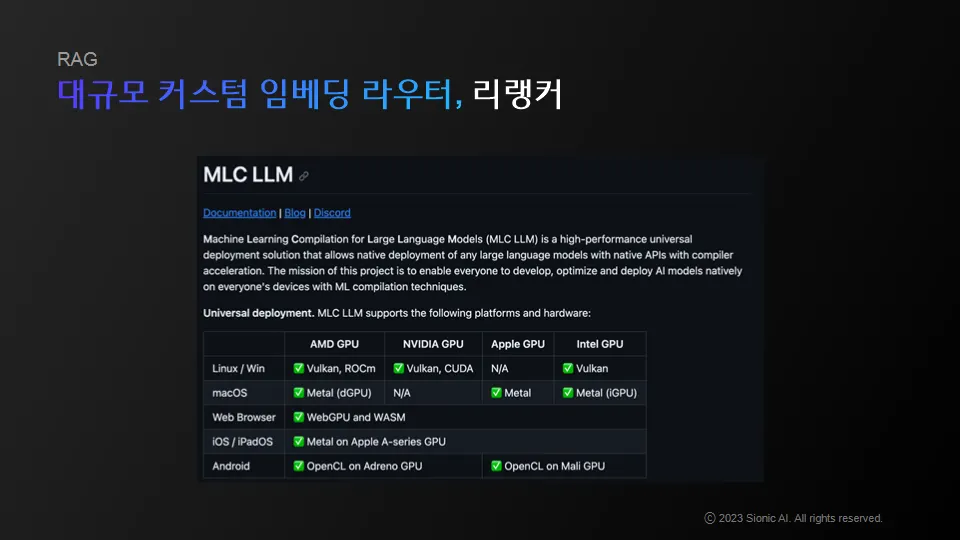

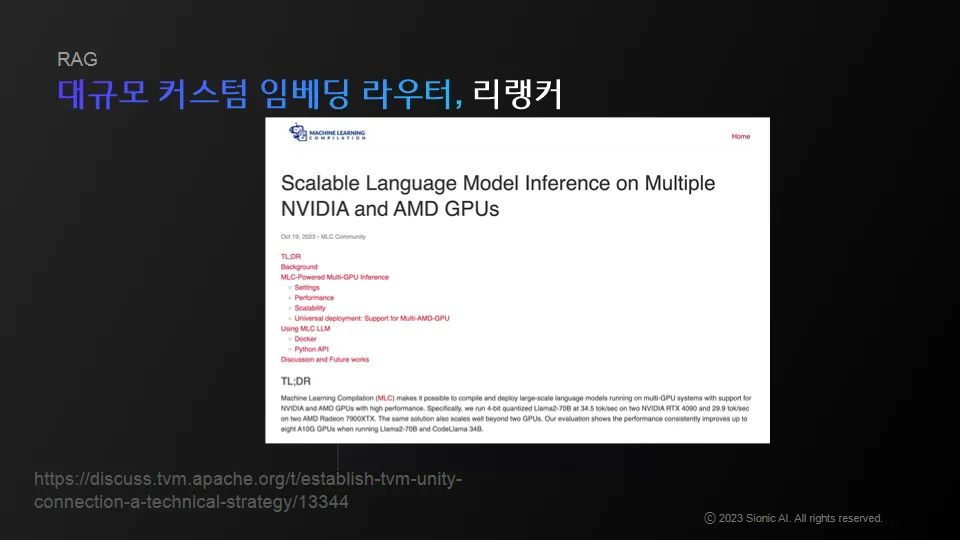

MLC와 같은 오픈소스 영역에 굉장히 큰 발전

•

최근에 Multi GPU와 AMD와 관련된 내용들도 릴리즈가 되기 시작

•

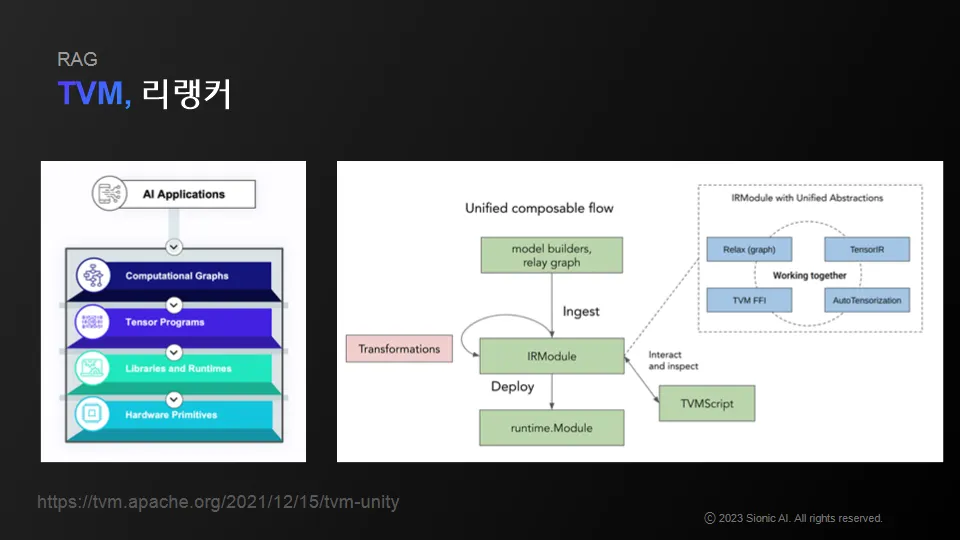

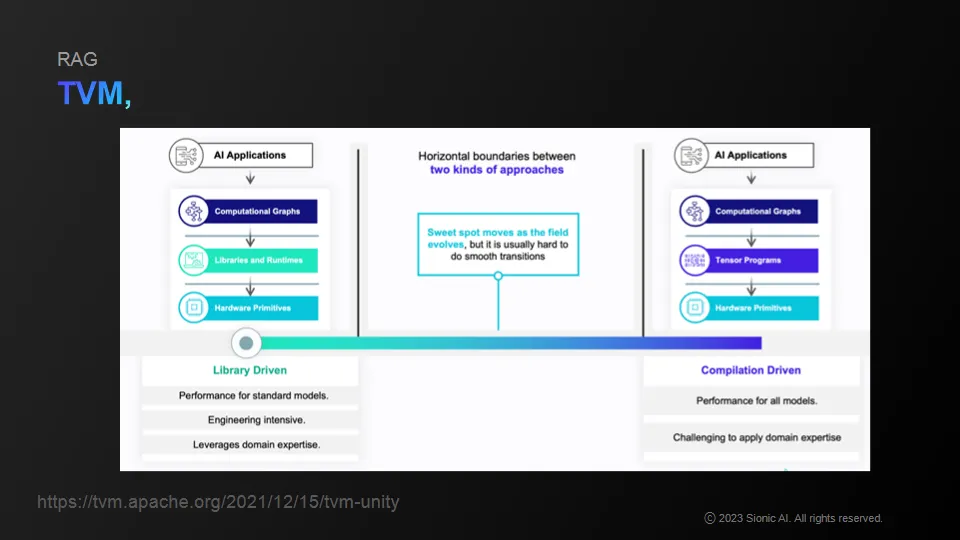

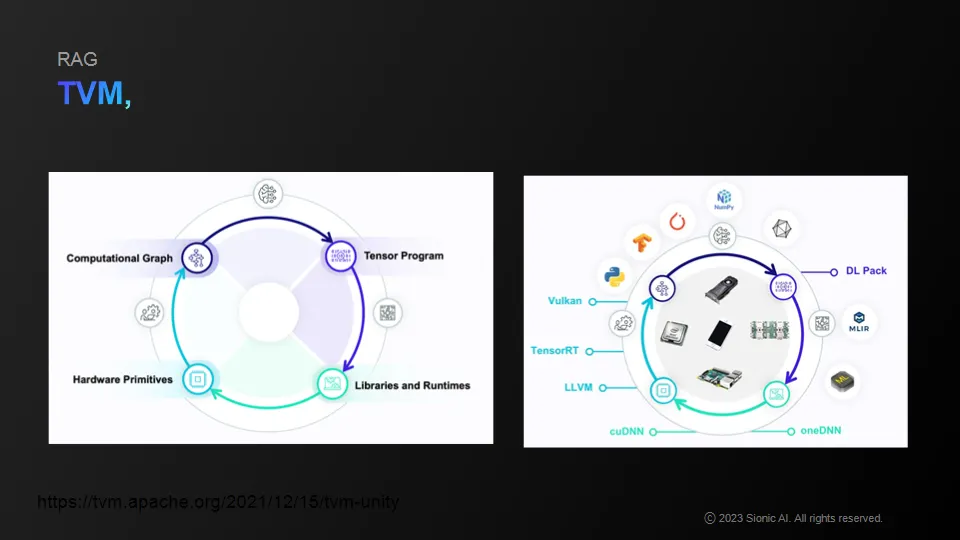

Apache의 TVM 등을 통해 ML 관련 파이프라인 혹은 실제 오퍼레이션들을 컴파일할 수 있게 됨