개요

•

Image Captioning에서 사용하는 기존 metric들의 경우 이미지에 없는 사물을 기술하는 hallucination 현상을 제대로 측정하지 못하는 경우가 존재함

•

이 논문에서는 특히 object hallucination 현상을 중점적으로 확인할 수 있는 새로운 metric인 'CHAIR'를 제안하고 어떤 요소들이 이러한 object hallucination을 만드는데 영향을 미치는지 분석을 수행

•

Method

•

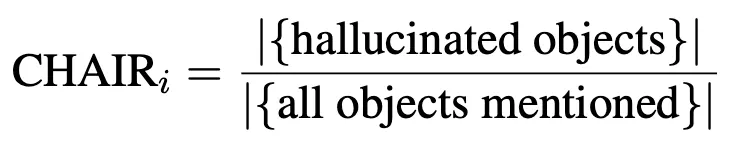

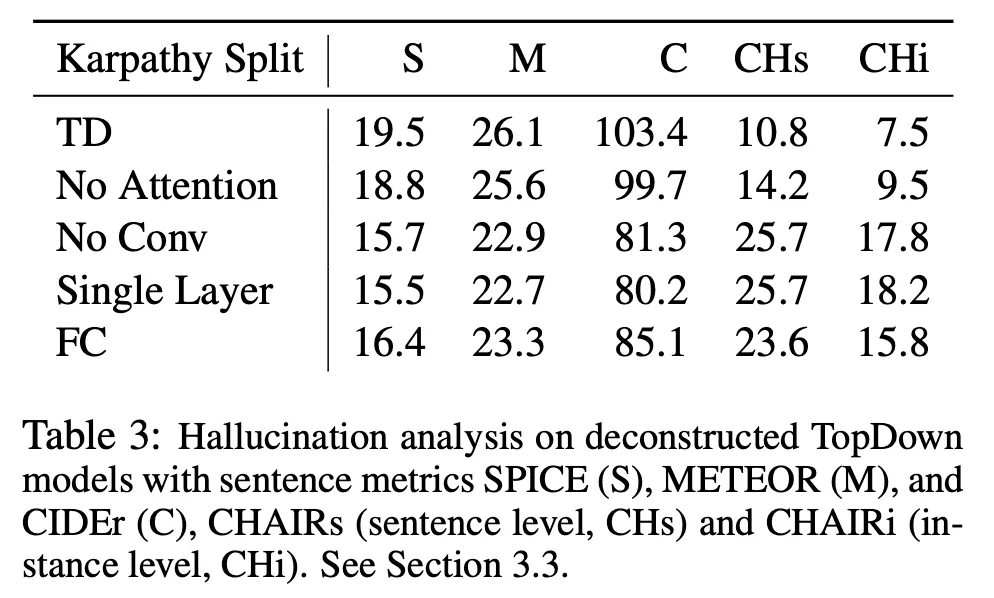

CHAIR (Caption Hallucination Assessment with Image Relevence) metric

◦

Per-instance : 전체 언급된 object 중 hallucination이 발생한 object 수의 비율

◦

Per-sentence : 전체 문장 중 hallucinated object를 언급한 문장 수의 비율

•

MSCOCO dataset을 대상으로 분석 진행

•

정답에 존재하는 object 및 그것의 동의어를 활용하여 hallucination 여부를 판단

•

"hot dog" 과 같이 복합어의 경우 hallucination 판단 과정에서 그 구성 단어인 "dog"가 잘못 사용되지 않도록 고려

Results

•

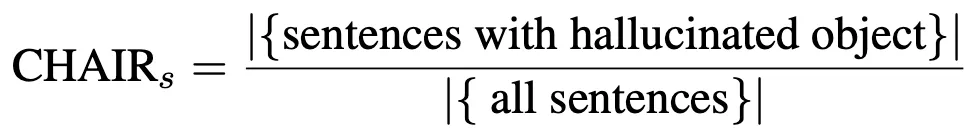

2018년 논문이다보니 실험에 사용한 대상은 ResNet 같은 예전 모델 위주

◦

기존 metric인 SPICE, METEOR, CIDEr에서 잘하는 모델이 일반적으로 hallucination이 적은(CHAIR가 낮은) 경향이 있으나 그렇지 않은 경우도 존재. 특히 CIDEr에 최적화된 모델은 오히려 hallucination 이 높은 편

◦

기존 metric에서는 self-critical loss로 학습한 경우 비슷하거나 더 나은(특히 CIDEr 점수) 모습을 보이나 CHAIR기준으로 더 안좋은 성능을 보임

◦

attention이 있는 모델이 전반적으로 더 나은 성능을 보임

•

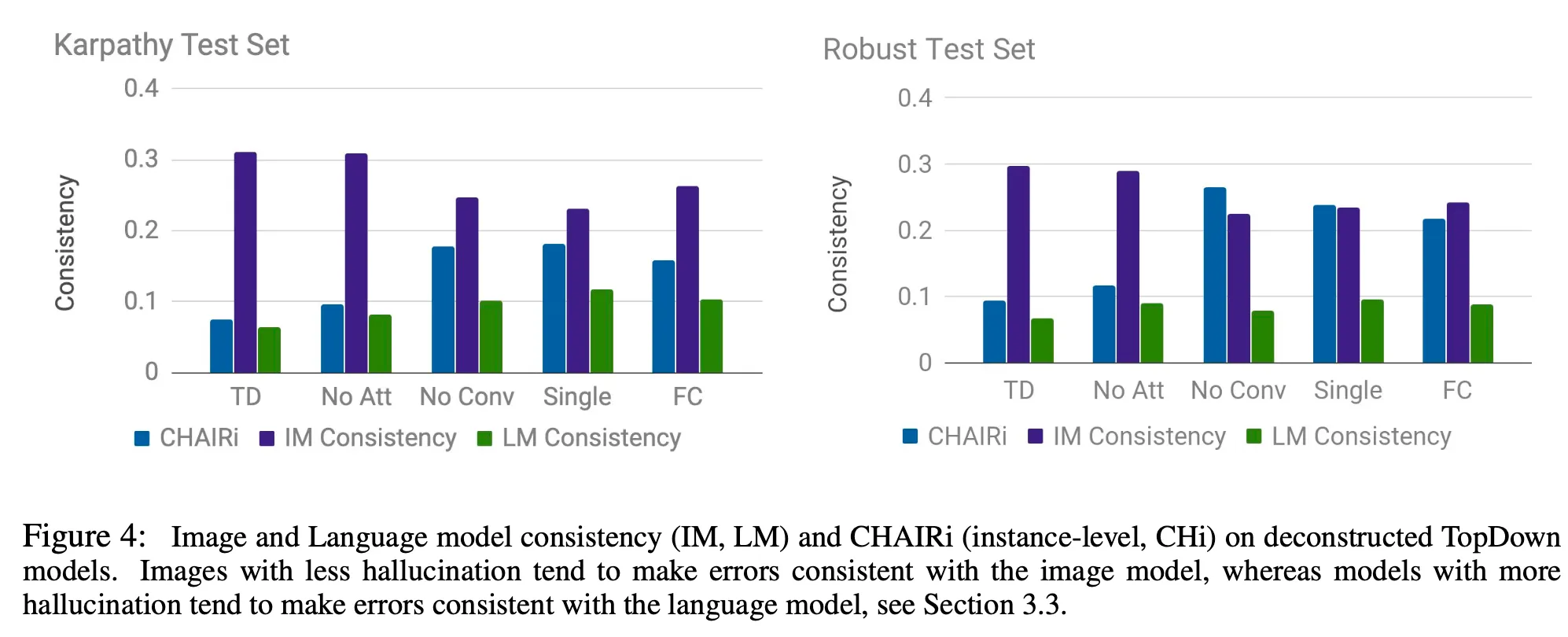

Convolutional Layer가 hallucination 성능에 가장 큰 영향을 미치며 attention은 비교적 minor한 영향을 미침. 이것으로 볼 때 실제 attention mechanism 보다는 입력 이미지의 spatial feature를 활용하는 것이 더 중요하다는 것을 알 수 있음

Further Analysis

•

어떤 요소가 hallucination을 발생시키는지에 대한 분석 진행

•

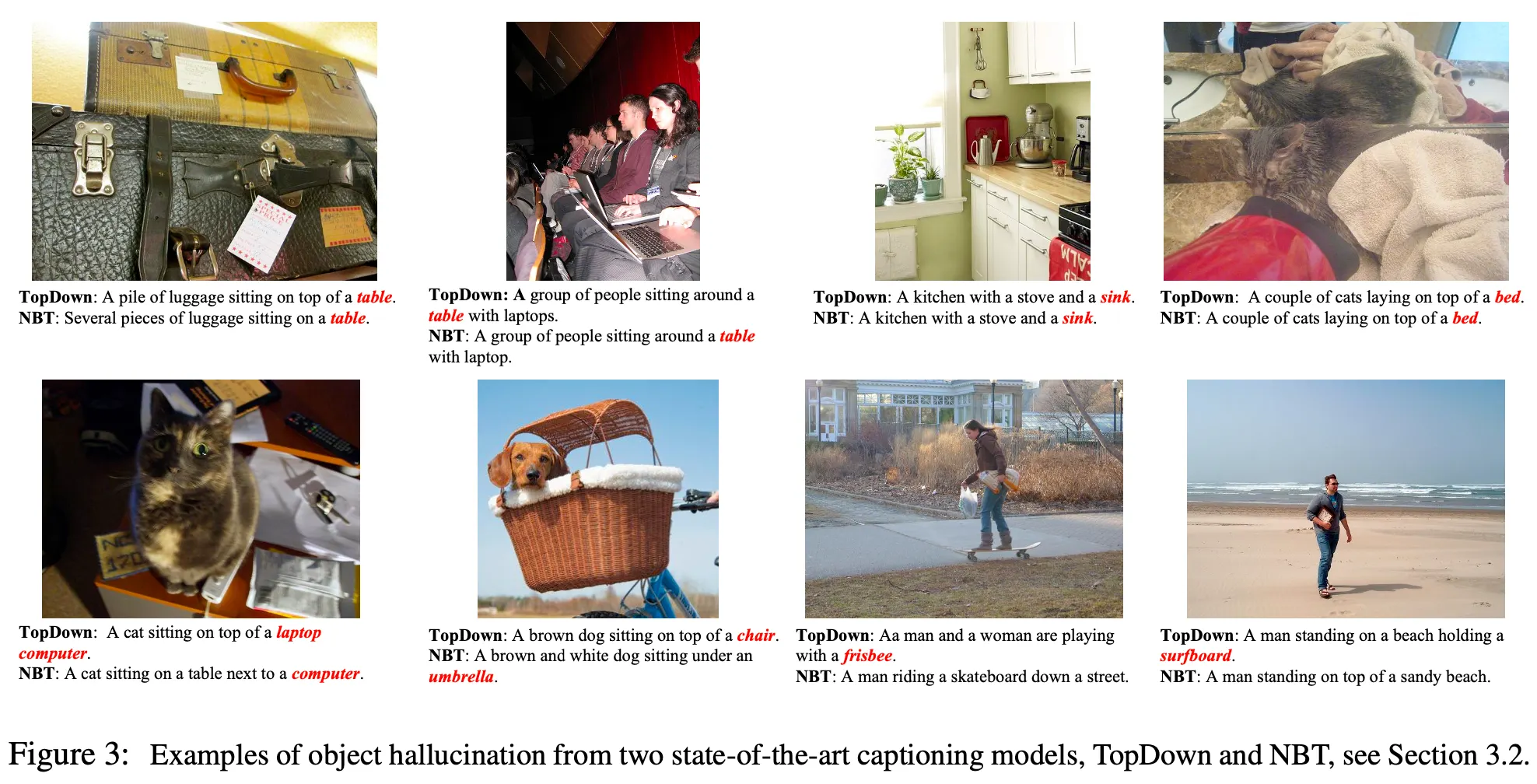

주로 가구 카테고리의 object들(e.g., dining table, bed 등)이 가장 높은 빈도로 환각이 발생

•

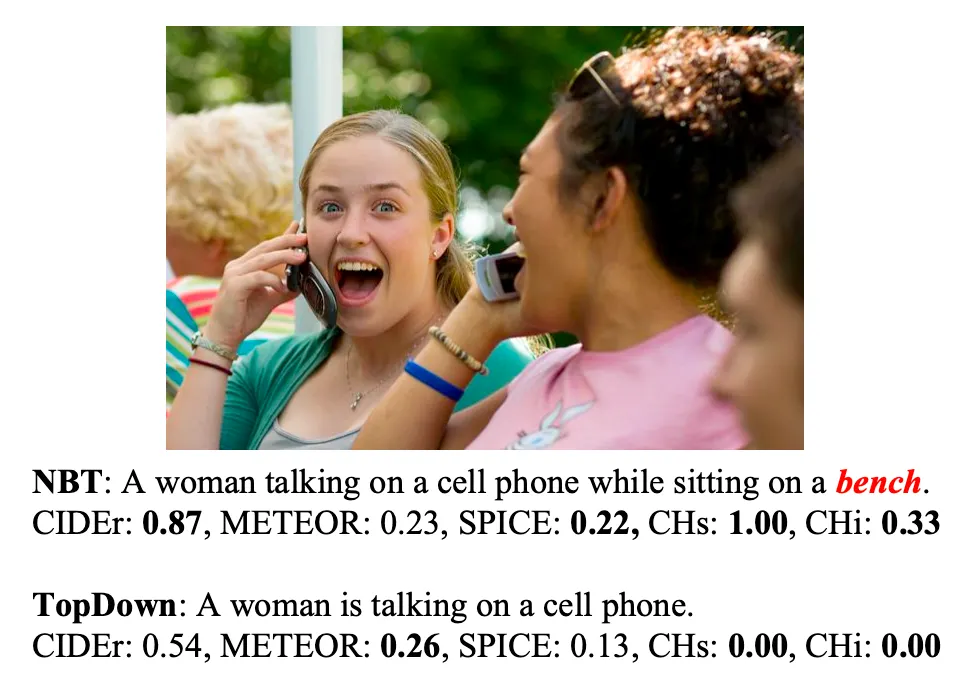

captioning text에 특정 단어가 출현하면 이미지에 없더라도 잘못된 object를 생성하는 경향이 존재

◦

sitting -> table, kitchen -> sink, laying -> bed 등

•

주어진 이미지의 scene에서 있을법한 물체가 환각으로 등장하기도 함 (e.g., 해변 사진에서 surfboard)

•

환각이 적게 발생하는 모델의 경우 image model과 관련한 환각 비율이 높은 반면 환각이 높은 모델의 경우 language model과 관련한 환각 비율이 높음